2023年1~2月はChatGPTが世間で大きな話題となりました。昨今のAIに関する技術の進歩はめざましいものがあります。

昨夏には、高品質な画像を生成できるAIが登場して大きな話題になっていました。それから半年ほど経過した現在では、AIが生成したイラストをあちこちで見かけるようになっています。最近になってようやく時間がとれたので試してみることにしました。

このページでは画像生成AIを自分のパソコン内(ローカル環境)に導入するにあたって気づいたことや実際に使用して気づいたことなどを簡単にまとめています。導入の具体的な手順は、優れたブログやまとめ記事が既に多数存在しているためここでは触れていません。そういうページを見ながら研究することが必須といえます。

私も使い始めて間もなく試行錯誤している段階ですが、今から始めようとした人が気になりそうな点や躓く点がいくつかあると感じたのでまとめておきます。なお、こちらの認識不足や間違いがあるかもしれません。そのため、この文章は随時、修正・追記していきます。

(2023年10月2日追記)今では短いアニメも簡単に生成できるようになっています。

(2023年12月15日追記)音楽生成AIは以下のページに解説があります。

- Stable Diffusionを利用してイラストを生成する

- 画像生成AIは誰でも使えるのか?

- 画像生成AIは無料で利用できますか?

- パソコンを持っていなくても使えますか?

- パソコンの知識がなくても利用できますか?

- 一般的なノートPCやデスクトップPCで利用できますか?

- (2023年3月22日追記)新しいAI画像生成サービス誕生!!

- どのような環境で利用していますか?

- グラフィックボードの性能の違いで何が変わるのですか?

- パソコンを買い替えたいのですがおすすめはありますか?

- 日本語で操作することができますか?

- 英語ができないとプロンプトの入力は難しいですか?

- AIイラストの生成は難しいですか?

- 「モデル」とは何ですか?

- 「VAE」とは何ですか?

- アニメのようなキャラはどうやって作るのですか?

- どのモデルがおすすめですか?

- 写真のようなリアルな人物はどうやって作るのですか?

- 思いどおりのイラストを生成することはできますか?

- 同じ人物を連続して生成することはできますか?

- 画像生成AIの利用は事前の情報収集が大切

- プロンプトを入力して画像を生成するときの注意点

Stable Diffusionを利用してイラストを生成する

画像生成AIは美麗なイラストを出力してくれる

画像生成AIは「プロンプト」と呼ばれるイメージに関する文字情報を指定することで、高品質なイラストをすぐに生成できる革新的な技術として注目されています。既に数多くのAIイラストが投稿されているようです。プロンプトは「呪文」ともいわれることがあります。

以下のイラストをご覧ください。これらは「Stable Diffusion web UI(AUTOMATIC1111版)」を導入直後に生成したものです。画質はブログ用に落としています。プロンプトは先人たちが公開されているものを一部改変して利用させてもらいました。

モデルは「Anything-v4.0.ckpt」です。最初の数十枚は導入したVAEが適用できていませんでした。そのため、灰色のフィルターが掛かったようになっています。VAEが必要なモデルは設定するのを忘れないようにしないといけません。

|

|

利用したプロンプトがファンタジーテイストということもあって、幻想的で綺麗なイラストが出来上がりました。2枚目は髪の色を黒に変更し、背景も変更したものになります。昨今のAI技術の素晴らしさには驚嘆するものがあります。

「moon(月)」「dress(ドレス)」「castle(お城)」などのプロンプトを上手く取り入れることでファンタジーらしさが増すようです。

|

|

ファンタジー風のものばかりを作成していたので、今度は現代風のものを試してみました。服装や背景を変えるだけでもそれらしくなります。

同じプロンプトを入力しても、出力される画像は毎回違います。シード値を指定することでほぼ同じ人物のイラストを続けて作成することもできます。

|

|

顔のアップは違和感を持つところがまったくないほどの出来映えになっています。

|

|

このように振り返った状態も簡単に作ることができます。

多くの方々の試行錯誤があって、今ではこのようなイラストがすぐに出力されるに至っています。それでも「服装」や「指先」などは奇妙な描写になることが少なくありません。

それと、画像はちょっときわどいものもあったので厳選して掲載しています。すぐにおPあNつを見せようとするのはやめなさい!w

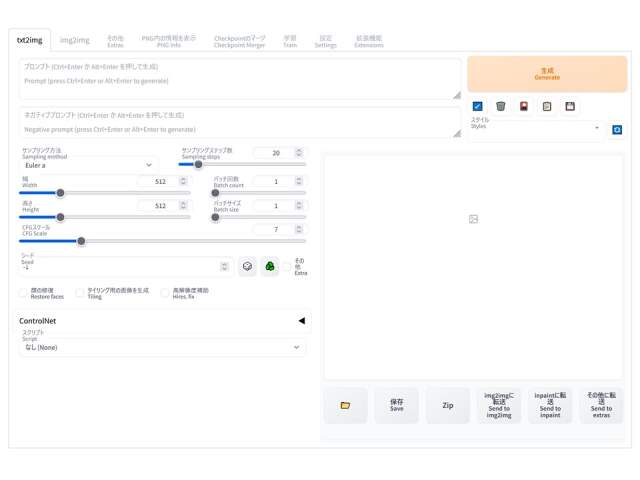

ここでは「Stable Diffusion(ステーブル・ディフュージョン)」をパソコン内(ローカル環境)にインストールして利用する方法を採用しています。ローカル環境を構築するためのツールが公開されています。そちらを利用して環境を作ってみました。「Stable Diffusion web UI(AUTOMATIC1111版)」を利用することによりブラウザ上で操作することでAIイラストを生成することができるようになります。

【使用】

「Stable Diffusion web UI(AUTOMATIC1111版)」

「Anything-v4.0.ckpt」

画像生成AIは誰でも使えるのか?

画像生成AIを初めて導入しようとするときに迷ったり疑問に思ったりする点をいくつか挙げてみます。パソコンに詳しくない方が気になる点を中心に取り上げています。

「Stable Diffusion」をパソコンにインストールして本格的に使ってみたいという方は、お時間のあるときにぜひご覧ください。

画像生成AIは無料で利用できますか?

AIサービス自体は、「NovelAI(ノベル・エーアイ)」のように有料サービス(サブスク)もあれば、「Stable Diffusion」のように無料で利用できるものもあります。

このページでは無料で使える「Stable Diffusion」の導入について言及しています。この「Stable Diffusion」にはいくつかの利用方法があります。

・「Stable Diffusion」を利用したアプリやWebサービスを使う

・「Stable Diffusion」をクラウド環境にインストールして使う

・「Stable Diffusion」を自分のPCにインストールして使う

「Stable Diffusion」をお試しで使ってみたいということであれば、スマホのアプリをアプリストアから検索して利用してみてください。また、Webサービスを利用する場合は、PC内にローカル環境を構築するよりも難易度は低いです。

それから、「Google Colab」などのクラウド環境を利用するという方法もあります。→4月21日頃から無料プランでは「Stable Diffusion web UI」が実行できなくなりました。有料プラン(Pro)ではまだ使えるようです。

本格的に利用したいということであれば自分のパソコンにローカル環境を構築して利用する方法を選択することになります。「NMKD Stable Diffusion GUI」または「Stable Diffusion web UI」を利用してローカル環境を構築することができます。通常は後者の「Stable Diffusion web UI」を導入します。

ここではローカル環境を構築して利用することを前提として話を進めていきます。

私はWindows環境で「Stable Diffusion web UI」を使えるように準備しました。モデルは「Anything-v4.0.ckpt」を利用しています。

「Stable Diffusion web UI」のインストール後にバイリンガル設定を導入しておくと、あちこちの解説サイトで用いられている項目名が理解しやすくなります。オススメ!!

「Stable Diffusion」はNVIDIAのGPUを使用するため、RTXシリーズなどの高性能グラフィックボード(=グラボ/ビデオカード)を搭載したパソコンが必要になります。

パソコンを持っていなくても使えますか?

いいえ、ローカル環境で利用することはできません。

しかし、先に述べたとおり、スマホやタブレットでもAIイラストのアプリを利用することができます。たとえば、「画像生成AI AIイラスト Stable Diffusion」というスマホ(iPhone)用のアプリがあります。

他にも「Stable Diffusion」を利用したアプリがたくさん出ているようです。そちらを調べてみてください。

パソコンの知識がなくても利用できますか?

自分PCにローカル環境を構築して利用する方法は、パソコンの知識が多少なりとも必要です。プログラムはできなくても大丈夫ですが、コマンドプロンプトは使います。そういうこともあって、エラーが出たときに対処することが難しいかもしれません。

一般的なノートPCやデスクトップPCで利用できますか?

いいえ、できません。推奨スペックを満たしていません。

「GeForce RTX 3060」等の高性能グラフィックボードを搭載したPCが必要です。ゲーミングPC(デスクトップ)やクリエーターPC(デスクトップ)を購入してください。ゲーミングPCであれば以下の製品と同等以上の性能が必要です。ひとつの目安にしてください。

なお、ゲーミングノートPCはVRAMの容量が明示されていないことがあります。公式サイトの仕様を確認すると6GB程度のこともあるため注意してください。

今からパソコン本体を購入されるならデスクトップPC一択です。ゲーミングPCのような高性能かつ拡張性のあるものを選んでください。ドスパラ、ツクモ、パソコン工房などのPC専門店に行ってください。店員さんが親切に教えてくれます。家電量販店はPCに詳しくない人も多いのでおすすめしません。

今ではアップデートによって当初より低スペックで動作するという情報があったように思います。OSはWin 7以降、VRAMは最低4GB、ストレージの空き容量は最低10GB以上となっています。しかし、どちらももっと多いほうが快適です。

(2023年3月22日追記)新しいAI画像生成サービス誕生!!

Microsoftの「新しいBing」にAI機能が追加されたことは以前から話題になっていました。今度はそれにAI画像生成機能が付加されました。このサービスを利用すると誰でも簡単にAI画像を作成してもらうことができます。

高価なゲーミングPCや高性能のグラフィックボードをお持ちでないという方はぜひ試してみてください。以下のページに詳しい解説があります。

今では初期バージョンと比べてとても綺麗なイラストを生成することができるようになっています。また、4月頃からプロンプトの日本語入力にも対応しています。

どのような環境で利用していますか?

私の環境は以下のとおりです。パソコンは新しくありませんし、それほど高性能でもありませんが、このようなスペックでも問題なく動作しています。

| OS | Windows 10 Home |

| CPU | AMD Ryzen 3600 |

| メモリ | 16GB |

| ストレージ | SSD 512GB |

| グラフィック ボード |

GTX 1660 Super(VRAM 6GB) (追記)↓ RTX 3060(VRAM 12GB)に交換 |

自作PCにするとコストを抑えることができます。

CPUとメモリはほどほどで十分のようです。タスクマネージャーを見る限り、これらの使用率は大したことがありませんでした。メインメモリはVRAMの代わりにはなりません。ストレージはモデルをどれだけ入れるかによって必要な容量が異なります。

一方、画像の生成はグラフィックボードに搭載されたVRAMを使用します。そのため、VRAMの容量が多いグラフィックボードが必要と言われています。VRAMの使用率を見てみると、画像の生成中は天井に張り付いた状態を維持しています。

グラフィックボードは「GeForce GTX 1660 Super」を使っていますが、画像が出力できないと書いている方もいました。こちらの環境では問題なく動作しています。(追記)グラフィックボードを「RTX 3060」に交換しました。

旧世代のグラフィックボードでも画像を普通に生成する分には問題ありませんが、効率化を図るために新しいグラフィックボードとの換装を検討しています。3月中に安くなっていたら買い替えるかもしれません。

なお、「GeForce RTX 3060」はVRAM8GB版もありますので絶対に間違えないでください! また、上位モデルの「GeForce RTX 3060 Ti」は性能自体は通常版よりも高いですが、VRAMが8GBなので選ばないでください。

「RTX 3060」の新品は価格の変動はありますが大体5万円前後で手に入ります(2023年3月時点)。

グラフィックボードの性能の違いで何が変わるのですか?

最新の高性能グラフィックボードを使うことで画像を生成する時間を短縮することができます。画像の生成は基本的にVRAMが使用されています。VRAMは512×512のような低解像度を除くとあればあるだけ使います。そのため、グラフィックボードに搭載されたVRAMの容量がもっとも重要といえます。VRAMが12GB以上のものを選んでください。

詳しくは次のページをご覧ください。グラフィックボードを交換すると快適さが格段に高まります。

参考までに、VRAM6GBのGTX 1660 Super は画像1枚(解像度512 × 512 px)の出力に40秒~50秒ほどかかり、5枚同時の出力では5分前後かります。ですので、1回あたりの出力は5枚に押えています。画像は後からリサイズすることも可能です。

その後、解像度を768×1024に設定して1枚生成してみましたが無事に出力されました。ただ、8分くらいかかりました。

性能の低いグラフィックボードを使い高解像度のものを出力しようとするともっと時間がかかるか、VRAM不足でエラーが出るかもしれません。高解像度かつ短時間で画像を出力するためには、20~30万円もする超高性能グラフィックボードが必要です。アップスケーリングに関しても同様です。それでも、使い方と状況によってはサーマルスロットリングがかかるかもしれません。熱対策は当然に必須です。

グラフィックボードは同性能のものであれば、シングルファンよりもデュアルファンやトリプルファンのほうが騒音はマシかもしれません。GTX 1660 Super は幸いにして静かです(いつもと変わらない)。

グラフィックボードを購入するときの注意点を以下にまとめています。

以下のような高性能グラフィックボードは、長さが30cm前後のものや3スロット分占有するものが多いため、小さなケースには入らないことがあります。製品のサイズを確認してみてください。

パソコンを買い替えたいのですがおすすめはありますか?

パソコンのことがよく分からないということでしたら、「ゲーミングPC」として販売されているデスクトップパソコンを選んでください。PC本体は15万円前後で手に入ります。その他、ディスプレイ、DPケーブル、キーボード、マウスなどが別途必要です。これらは既存のものを使い回すことができます。

パソコン専門店(ドスパラ、ツクモ、パソコン工房など)の店員さんに「RTXシリーズのグラフィックボードでVRAMが12GB以上ある製品が欲しい」と伝えると最適な製品を教えてくれると思います。店員さんもVRAM12GBというだけで察してくれます。

パソコン専門店では、最近になってからゲーミングPCのVRAMの容量を値札に明記するところが増えてきています。それだけAI関連の需要が高まっているということです。VRAMの多いグラフィックボードは、機械学習、深層学習(ディープラーニング)、AI関連の処理に最適です。

予算が潤沢な方はRTX3090やRTX4090の搭載された上位モデルのPCを選ぶと、解像度を上げても軽快に動作させることができます。ハイエンドのグラフィックボードはVRAMが24GB程度あるものが多いです。しかし、ハイエンドのグラフィックボードは価格が高くてそれだけで良いパソコンが買えてしまうほどです……。

日本語で操作することができますか?

UIを日本語化することができます。日本語化することで一般的な操作において困ることはありません。

ただし、プロンプトは「英単語」や「英文」で入力しなければいけません。

英語ができないとプロンプトの入力は難しいですか?

いいえ、英語ができなくても大丈夫です。

英文は「DeepL」や「グーグル翻訳」またはオンライン英和辞典等を活用してください。もちろん、検索も使えます。単語がメインなので「Tシャツ 英語」と検索すると「T Shirt」と出てくるので問題ありません。

あるいは、文章を「ChatGPT」に翻訳してもらうというのもアリです。

先ほど紹介した bing image creator は、4月頃からプロンプトの日本語入力にも対応しています。また、最近になって初期バージョンとは違って綺麗なイラストの生成も可能になっています。アカウントを作成すれば誰でも短い街時間で気軽に美麗なイラストを生成できます。

AIイラストの生成は難しいですか?

いいえ、AIイラストを生成するだけであればとても簡単です。

ソフトウェアの準備が整ったら、プロンプトの入力欄に出力して欲しい画像を表現する言葉を入力します。そして、その下欄にあるネガティブプロンプトの入力欄には出力して欲しくない要素を列挙します。

その後は「生成」ボタンを押すだけです。しばらく待つと画像が出力されます。待ち時間はPC環境(主にGPU)によって大きく変わります。

しかしながら、想像に近い画像を生成してもらうためには、創意工夫と試行錯誤が必要です。しかし、最近では「ControlNet(コントロールネット)」を利用した新しい手法が普及しつつあるようです。

「ControlNet」を活用することで登場人物に思いどおりのポーズをとらせることができるようになります。詳しくは以下のページをご覧ください。

「ControlNet 1.1」がリリースされています。

「モデル」とは何ですか?

「Stable Diffusion」を利用した画像の生成は、特定の「モデル」を追加することが前提です。さまざまな「モデル」が配付されていますので、描いてもらいたい内容に応じた「モデル」を追加します。

また、使用する「モデル」の推奨する「VAE」というファイルが用意されていることがあります。その場合はそちらもあわせてダウンロードして所定のフォルダに配置してください。

「モデル」によってリアルな人物の描写が得意なものや、デフォルメされたキャラクターの描写が得意なものまで様々です。たくさんの「モデル」が生み出されているようですが、とりあえず有名なものを選んでおけば間違いありません。

アニメ調にしてもリアルよりにしても様々な描き方があると思います。公開されている「モデル」の中から好みのものをいくつか選んでひとつずつ試してみる必要があります。有名なモデルの画像を比較しているページがたくさんあります。

実写系のリアルな三次元モデルは「ChilloutMix」が有名です。リアルな人物の画像をTwitterで見てみると、多くの方がこのモデルを使っていることが分かります。

自分でオリジナルのモデルを作成することも可能です。操作に慣れた頃に試してみてください。

また、プロンプトの効果は「モデル」によって変わることがありますので、その「モデル」に応じてプロンプトを追加したり削除したりして試行錯誤しなければなりません。

それと、「モデル」はバージョン違いのものがあったり、軽量版があったりと様々ですので、説明をよく読んでから適切なファイルをダウンロードしてください。生成される画像は、バージョンが違うだけで大きく異なることもあります。その程度もまた「モデル」によって異なります。

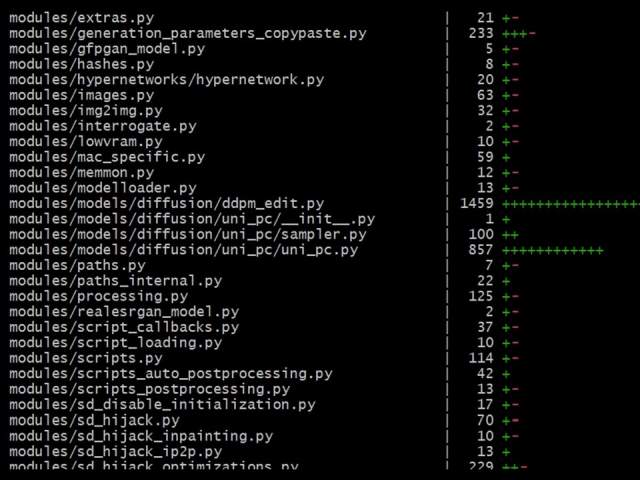

同一の「モデル」でもファイルの拡張子が「.ckpt(チェックポイント)」となっているものと「.safetensors(セーフテンサーズ)」となっているものがあります。その場合には後者の「.safetensors」版をダウンロードしてください。

ファイルの変換方法は以下のページをご覧ください。

「VAE」とは何ですか?

「VAE」は輪郭線や色彩の描写を補完するための要素が盛り込まれたファイルのようです(間違っていたらすみません)。「VAE」ファイルがないとエラーが出たりグレーっぽい画像が生成されたりすることがあります。

各モデルのダウンロードページやファイルページをよく見てみると「vae」と付いた名称のファイルが並んでいることがあります。それがある場合は「モデル」と一緒にダウンロードして指定のフォルダに入れてください。

「モデル」とあわせて、「VAE」を指定したフォルダに移動します。その後に、SDの設定で使いたい「VAE」を指定します。

また、「モデル」によっては既存の「VAE」の使用が推奨されていることもあります。その場合は詳細が「モデル」の説明欄に書かれています。

(3月20日追記)「VAE」ファイルの一部が WindowsDefender によって脅威「Trojan:Win32/Casdet!rfn」として検知され隔離・削除されてしまうようです。誤検知の可能性もありますが、念のために当面の間は別の「VAE」で代用しましょう。

アニメのようなキャラはどうやって作るのですか?

アニメのようなキャラクターを生成することを得意としているモデルを導入します。さまざまなモデルが発表されている中で、どのモデルを選ぶかでイラストのタッチや雰囲気がガラリと変わります。

3次元よりのイラストを作成する場合は、それが得意なモデルを選んで導入することになります。

モデルごとの特徴が生成されたイラストと併せて紹介されています。そういう記事を読んでみてください。

髪色や髪型はそれなりに自由に変えられます。見本の画像は以下のページにたくさん掲載されています。

また、プロンプトを使い分けることで豊かな表情を表現することも可能です。

どのモデルがおすすめですか?

どういう画像を生成するのかによって選ぶモデルは違います。好きなものを選んでください。後から追加することはいくらでもできます。いずれのモデルもファイルサイズが2GB~8GBと大きい点にご注意ください。

このページにあるようなアニメ調のイラストであれば「anything-v4.0(huggin Face公式サイトのモデルのページ)」というモデルはいかがでしょうか。とりあえず、このモデルで綺麗なイラストを描いてもらうことができます。使い方に慣れたら他のモデルを試してみるという方法でよいかもしれません。

背景も綺麗に描いてもらうことができますよ。

上のページにアクセスして、タブを「Files」に切替えると「anything-v4.0.ckpt」というファイルがあります。そちらをダウンロードしてください。「.safetensors」版のいずれかのファイルをダウンロードしてください。たとえば「anything-v4.0-pruned.safetensors」など。

このほかにも同じようなファイル名でバージョンの違うものがたくさんあります。それによって、イラストの雰囲気が多少違うかもしれません。

なお、このモデルは「VAE」と呼ばれるファイルの使用が推奨されているようですから、そちらも同時にダウンロードしておいてください。上のファイルのすぐ下に「anything-v4.0.vae.pt」というファイルがあります。

ファイルの変換方法は以下のページをご覧ください。

各種「VAE」ファイルは WindowsDefender では検知されなくなりました。

ーーーーーーーーーーーー

他の項目にも記載していますが、3月19日頃あたりから「anything-v4.0.vae.pt」を含む複数の「VAE」ファイルが WindowsDefender の定義ファイルの更新によってトロイとして認定されるようになっています。他のウイルス対策ソフトでは反応がないようですが……。

「VAE」ファイルが必要な場合は別のもので代用してください。以下の「VAE」のものを使っていますが、こちらの環境では今のところ何も検知されていません。

(二次元より)

「vae-ft-ema-560000-ema-pruned.safetensors(Hugging Face)」

(三次元より)

「vae-ft-mse-840000-ema-pruned.safetensors(Hugging Face)」

写真のようなリアルな人物はどうやって作るのですか?

Twitter等で注目を集めているリアルなCGは、そういう描写の得意な「モデル」を入れる必要があります。

それに加えて、超高画質かつ超高精細な画像は、グラフィックボードの性能が何よりも重要になってきます。VRAM24GBの「RXT 4090」や「RTX 3090」を手に入れてください。以下は参考です。値段を見るとびっくりしますよ……。

思いどおりのイラストを生成することはできますか?

いいえ、困難です。

何よりも困ることは、手足や指先の描写が難しいという点です。とにかく、使いこなすまでは試行錯誤と根気が必要です。

細かい指定をせずに画像を出力するとバストアップ(頭から胸部まで)のイラストが多くなりますが、細かく指定して全身を出そうとすると足や指が増えるといったことがそれなりの頻度で起こります。

他にも、服の袖が一部なくなっていたり、靴下が途中で途切れていたりといったことが起こってしまいます。

超美麗なイラストを生成することは容易ですが、プロンプトの入力だけでは服装やポーズなどの細かい要素をすべて思いどおりにすることはできません。

「ControlNet」という拡張機能を利用することでポーズがある程度自由に指定できるようになります。詳しくは以下のページをご覧ください。

同じ人物を連続して生成することはできますか?

はい、ある程度はできます。

画像を出力したときに同時に出てくる「シード値」を利用することで、ほぼ同じ人物のポーズや背景をかえたイラストを次に出力するといったことが可能です。

ただし、服装や装飾品などの細かい部分がどうしても変わってしまいます。髪型や髪色が変わることさえあります。

(2023年5月27日追記)特定のキャラクターの画像が1枚あれば、同じような画像を連続して生成することが可能です。詳しくは以下のページをご覧ください。

画像生成AIの利用は事前の情報収集が大切

新しいものが次々に生み出されている状況

画像生成AIが登場して以降、真っ先に導入して試行錯誤された先人たちがブログやWikiに貴重な情報をまとめてくれています。

ただし、画像生成AIはその内容が日々進化しており、バージョンアップが行われたり、新しいモデルが登場したりといったことがあるため、古い情報では対応できないことがよくあります。

ある記事のとおりに進めたのにエラーが出るといったことが普通に起こります。それはその記事に問題があるのではなく、バージョンやPC環境など諸要因の違いによるものです。

検索時は期間を直近2ヵ月程度に絞っておくことがもっとも重要です。次から次へと新しいものが生み出されている状況のため、最新の情報を得るようにしてください。

Stable Diffusion導入の大まかな流れ

ここでは大まかな流れだけを示しています。詳細は次の項目のリンク先を見てください。

1.自分のパソコンで利用できるかどうかを確認します。タスクマネージャーを開いてGPUの型番とVRAMの容量を調べてください。特に問題がなければ次に進みます。

2.使用したい「モデル」のファイルを探してダウンロードします。「VAE」が必要な「モデル」は「VAE」のファイルもあわせてダウンロードしておきます。ファイルは「Hugging Face(ハギングフェイス)」というAI関連のコミュニティサイトにあります。これらの行程は「5」の後でもOKです。

3.「Python(パイソン)」をインストールします。これは「Python」というプログラミング言語の開発環境をインストールするということです。バージョンを間違えるとStable Difussionが動作しません。指定されたバージョンをインストールしてください。

4.「Git(ギット)」をインストールします。この「Git」を経由して「Stable Diffusion web UI」をインストールすることになるのです。

5.「Stable Diffusion web UI(AUTOMATIC1111版)」をインストールします。インストール場所は適切な場所に設定しなければなりません。上位のフォルダも含めて日本語の文字や全角スペースなどが含まれていないか確認してから場所を決めてください。また、SSDの容量がモデルを入れたときにも十分残っているか確認してください。

6.使用したい「モデル」を「Stable Diffusion web UI(AUTOMATIC1111版)」内の指定されたフォルダに移動します。「VAE」がある場合は、それも指定のフォルダに移動します。

7.「stable-diffusion-webui」を起動する。「stable-diffusion-webui」フォルダにある「webui-user.bat」ファイルを実行するとファイルのダウンロードやインストールなどの作業が始まります。これには時間が掛かります。

インストール方法を徹底的に調べてから導入する

新しいサービスは、導入方法や使い方が分からずに何から手を付ければよいのかさえ分からないものです。

ローカル環境を構築するためには入念な準備が必要です。フォルダのパス名に日本語が含まれていたり、Pythonのバージョンが違っていたりするとエラーが起こることもあります。また、PC環境によってよく分からないエラーが起こって動作しないことがあります。

パソコンのことがよく分からないという方は、情報収集をしっかり行って、分からないことを全部調べてから導入するようにしてください。

私もブログに載っていた記事を見ながらインストール作業を進めたのですが、途中でエラーが生じて動作しませんでした。その後、色々と調べ直して使えるようになりました。情報収集を除くと導入して使用できるまでに2時間くらいかかりました。

また、画像を生成するためのモデルがいくつも出ており、どれを使用するかによって出力される画像の特徴や品質がまったく異なります。だから、どのような目的で画像生成AIを利用するのかを明確にしておく必要があります。

実写のような人物を描きたいのか、アニメのようなキャラクターを描きたいのか、綺麗な風景を描きたいのか、電車や車などの物を描きたいのか等によって導入するモデルや重要となるプロンプトが異なります。

ローカル環境を構築する前に情報を収集してください。有益な情報を掲載されているWikiやブログ等のサイトがたくさんあります。そういうところの情報をくまなくチェックしてから導入されると失敗が少なくなると思います。

https://wikiwiki.jp/sd_toshiaki/

(左側「ローカル版導入」のページ)

「Stable Diffusion」の導入と日本語化、そして画像生成に関する研究を行う上で必見のWikiです。私も最終的にこちらの情報を参考にインストールと日本語化を行いました。貴重な情報がたくさん掲載されています。インストールに関する動画もアップされているようです。

【重要Webサイト】

Python(プログラミング言語)

https://www.python.org/

Git(バージョン管理システム)

https://git-scm.com/

Hugging Face(AI関連のコミュニティサイト)

https://huggingface.co/

↑ここに色々あります。

AUTOMATIC1111 / stable-diffusion-webui (ローカル版SD)

https://github.com/AUTOMATIC1111/stable-diffusion-webui

生成したイラストの使用には注意が必要

モデルによって利用許諾が異なるため、イラストの使用について調べておく必要があります。商用利用は特に注意が必要です。

もうひとつの重要な点は、AIによって生成された画像は、あくまでもAIによって描かれたものであることを利用者が理解しておかなければならないということです。

AIの「img2img(画像から画像を作成する)」機能は、既存のイラストを読み込んで、それをもとにして新しい画像を生成することができます。けれども、その場合には元になったイラストの影響を顕著に受けています。人様のイラストを無断で読み込んで、出力された画像をあたかも自分で描いたかのように主張することは大きな問題があります。

せっかく新しい技術が登場しても、その利用方法を誤ってしまうと皆が困ってしまう上に、魅力ある技術の進展が滞ってしうかもしれません。

プロンプトを入力して画像を生成するときの注意点

プロンプトの記述

プロンプトは生成したい画像のイメージを言葉に置き換えたものといえます。イメージに近しい言葉を入力して、有効なプロンプトを見出して活用するといった流れになります。

プロンプトを入力して画像を生成することは、見方を変えると画像を大量に生成して「あたり」を見出す作業といえるかもしれません。

求めている画像を出力してもらうために、Danbooruタグを理解しておくことが必須といえます。それと同時に、先人たちが公開してくださっているプロンプトとネガティブプロンプトを活用させてもらうことが重要です。

プロンプトの有効性

利用するモデルによってプロンプトの有効性がまったく異なります。ある記事で「○○○」というプロンプトが特定の姿勢に有効とあっても、そのプロンプトを別のモデルに適用してもほとんど効かないといったことが普通にあります。

自分の環境において無効なプロンプトと有効なプロンプトを判別して上手く使い分ける必要があります。

とはいえ、一見して効果がないように思えるプロンプトも潜在的な影響力を持っていたり、他のプロンプトとの相互の影響があったりするかもしれません。

また、「形容詞」や「色」が他の要素に掛ることがあるようです。この場合は表現を変えたり位置を変えたりする必要があります。

プロンプトの順序

語順はAIイラストの生成に強い影響を及ぼします。前に置いた要素がより重視されることがあります。もちろん、そうでないこともあります。

中盤に配置していたプロンプトを二番目に配置し直しても効果が見られなかったので、一番目に再配置したところ明らかな効果が見られました。

このように、プロンプトを後に置いて効果が反映されなければ、文頭に再配置して様子をみるといった工夫が必要です。

プロンプトの近接性

これは個人の感想ですが、同じカテゴリのプロンプトは隣同士で並べた方がよさそうな気がします。なによりも編集しやすいです。

以下の要素とも関連しています。

プロンプトの組み合わせ

プロンプトは、作品のクオリティに関するもの(例:super fine illustration, 4Kなど)、人物の描写に関するもの(例:1 boy, smile, bob cutなど)、構図や状況に関するもの(例:sit in a chair, cinematic angleなど)、場所や背景に関するもの(例:school, moon in the skyなど)、エフェクトに関するもの(spot light, sunlight)などを、うまく組み合わせて試してみてください。

また、プロンプトを矛盾させないような組み合わせにするとよいかもしれません。矛盾をはらむ二つのプロンプトを配置すると片方が優先されることもありますが、変な画像が出力される確率も上がるように感じます。

プロンプトの関連性

関連性の高いものを列挙することで、想像に近いイラストを生成されやすくなります。

たとえば、ファンタジー世界のゲームやアニメに登場しそうなキャラクターを作りたいというときに、「sword(剣)」「armor(鎧)」「fantasy(ファンタジー)」のような言葉をプロンプトに盛り込んで試してみます。

プロンプトの数量

プロンプトを色々と入力して試してみます。

プロンプトを盛り盛りにしなくても、シンプルな記述で望ましい結果が得られることが多いように感じました。これは私の気のせいかもしれません。モデルによっても違うかも。

上手くいかない場合は余計なプロンプトを除外してみてはいかがでしょうか。

プロンプトの変更

最初は好きに書いてみるのが面白いと思います。

使い方に慣れてきたらプロンプトの変更を一度にたくさん変えずに、ひとつだけ変えて様子をみるといったやり方にしたほうがよいかもしれません。そのほうが変化は分かりやすいです。

新しいプロンプトをひとつ追加することで生成されるイラストが大きく変化することもあれば、ほとんど変化しないこともあります。プロンプトの良し悪しは必ずメモしておいてください。次に活かせます。

ネガティブプロンプト

たとえば、「flat color(単調な色味)」「poor quality(低品質)」「text(文字)」などのように画像の劣化を防ぐための文言を入れておきます。

既にあちこちで公開されているネガティブプロンプトの見本のいずれかを入れておけば間違いないと思います。ネガティブプロンプトは、毎回の画像生成においてほぼ変えていません。

綺麗なイラストを生成するために

公開されているプロンプトをそのまま試してみることが、よい結果を出すことに繋がります。

プロンプトについて知りたい方は以下のページもあわせてご覧ください。

どういうプロンプトが何に影響を与えているのかをひとつずつ変更して検証する必要があります。

ポーズを自由に指定する

プロンプトを入力して画像を出力していると、人物の姿勢が思った通りにならないという問題が起こります。プロンプトとして用いる言葉や表現を変えて、相当の試行錯誤を経て思いどおりの姿勢を取ってもらうといった根気の要る作業を行わなければなりません。

ところが現在では「ControlNet」を利用することでポーズを指定して画像を出力することができるようです。しかも、棒人間や線画を基にして画像を生成したり、ポーズを取った画像を基にして画像を生成したりすることが容易にできるようになっています。これと併せて、指を適切に表現する方法なども考案されているようです。

このように次から次へと革新的な技術が登場しており、利便性が高まっているという現状があります。そういうものを利用者が常に学び続ける必要があります。

私も始めたばかりで日々勉強中ですので、これから始めようとお考えの方は一緒に進めていきましょう!